«Fake news», notizie false. Se ne parla molto in questi giorni per via del video manipolato su Matteo Renzi trasmesso da Striscia la Notizia. Come già analizzato da Il Sole 24 Ore nel seguente articolo, il fenomeno è oggetto di particolare discussione con riferimento

ad Internet e al ruolo centrale recitato dai social network quale fonte d’informazione. Un contesto problematico se, come

sottolinea CBInsights, circa il 52% del traffico online (soprattutto nelle piattaforme social) è generato da Bots. Cioè software

in rete costruiti ad hoc per fingersi esseri umani. Al di là di ciò una domanda è d’obbligo: come vengono costruite le notizie

false?

È la stessa CBInsights che, in un report, fornisce una descrizione di alcune tra le più interessanti catene di montaggio

della “Fabbrica” delle “fake news”. Una di queste riguarda i video. Immagini di importanti personaggi, ad esempio politici,

che potrebbero essere manipolati.

Una mistificazione potenzialmente da usare per screditare lo stesso leader (magari durante una campagna elettorale). Oppure

per creare tensioni diplomatiche e incidere sulle decisioni geo-politiche di un Governo.

Così lavora l’Artificial intelligence

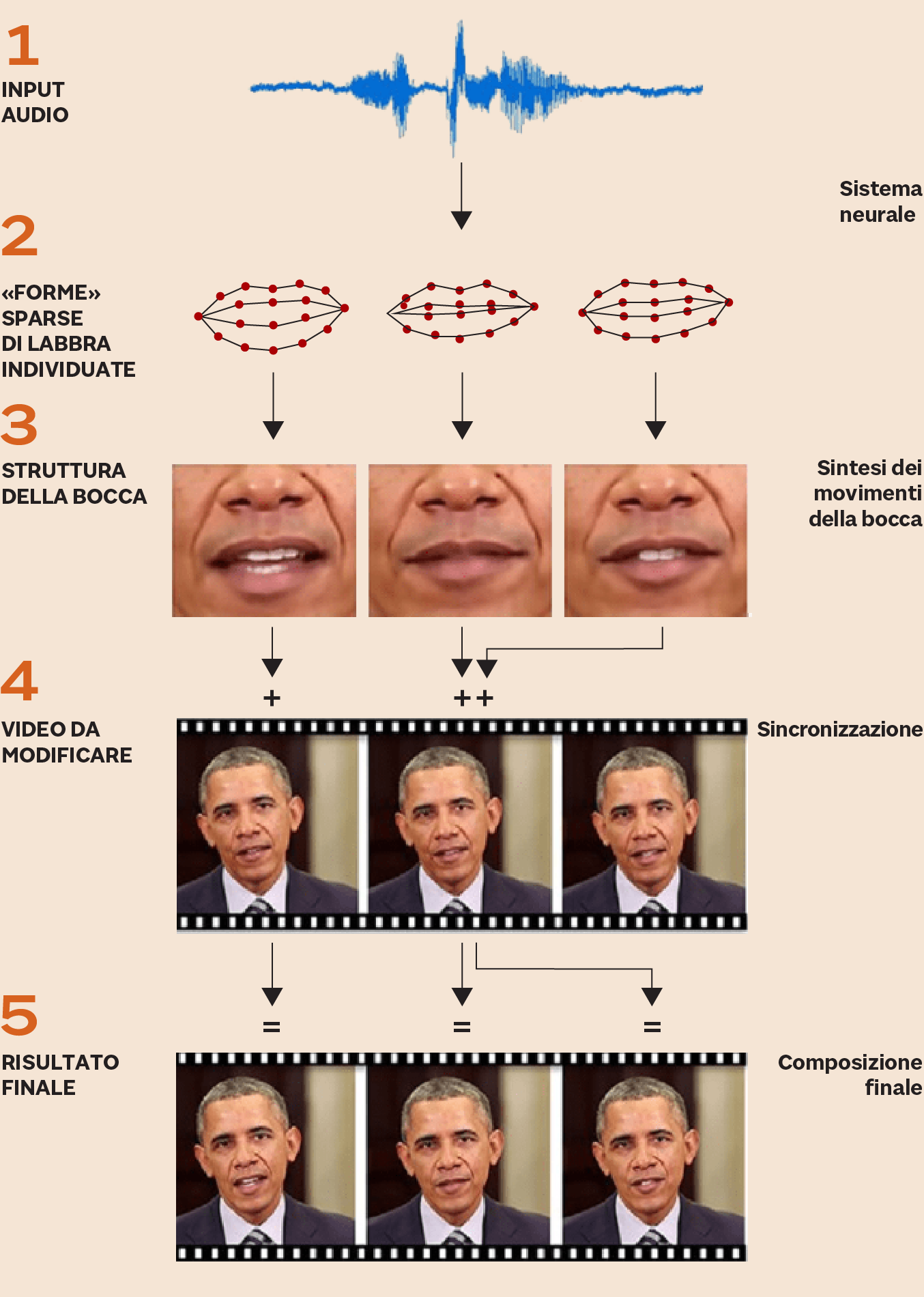

Così CBInsights sottolinea una ricerca effettuata da alcuni scienziati dell’Università di Washington. Gli esperti hanno dapprima

preso un file audio di Barack Obama. Successivamente, utilizzando un sistema neurale, hanno individuato, attraverso l’analisi

di milioni di immagini dell’ex presidente degli Stati Uniti, diverse forme e posizioni casuali della sua bocca e dei suoi

movimenti. Poi l’artificial intelligence (Ai) ha definito la corretta sequenza delle posizioni che si adattava al file audio.

Successivamente il filmato “costruito” della parte inferiore della faccia di Obama è stato sintetizzato all’interno di un

video in cui l’ex inquilino della Casa Bianca diceva tutt’altro. L’Ai è stata in grado non solo di ricomporre i movimenti

della bocca ma anche particolari quali, ad esempio, il movimento delle rughe attorno alle labbra oppure al mento. Il risultato

finale? Una clip audio-video ad alta definizione in cui Obama pronuncia in maniera assolutamente naturale cose dette in un’altra

occasione.

Fonte: University of Washington

I vantaggi dell’intelligenza artificiale

Può obiettarsi: simili meccanismi, in linea di massima, sono conosciuti da tempo. Dov è la novità? La risposta si articola

su di un duplice piano: il primo è quello dell’uso dell’Ia. Il sistema neurale riesce in poco tempo, e con un basso dispendio

di energie, a realizzare il video. Nel passato ci sarebbe voluto l’intervento di esperti di post-produzione dei filmati.

Non solo. Il lavoro sarebbe stato molto complicato, lungo e noioso. C’ è poi il secondo piano della risposta: quello della

precisione. Certo: anche con l’intervento dell’Artificial intelligence rimangono possibili sbavature. E, tuttavia, il livello

del nuovo video è di alta qualità. Tanto che è molto, molto difficile (se non impossibile) capire con l’occhio umano che il

video è falso.

Così si cambia l’espressione facciale

La situazione, a ben vedere, si ripete in un’altra situazione (guardate il video qui sotto). Vale a dire quella descritta in un interessante esperimento realizzato da alcuni scienziati della Stanford University,

dell’University of Erlangen-Nuremberg e del Max Plank Institute for Informatics. In questo caso i ricercatori hanno mostrato

come sia possibile, rimanendo nel mondo online, ricostruire in tempo reale un video presente in rete, sfruttando una semplice

webcam. In particolare la faccia di un attore, ripreso dalla stessa webcam, è in grado di modificare l’espressione del personaggio

nel video. Nella descrizione dell’esperimento gli scienziati hanno sottolineato come la metodologia in oggetto può, ad esempio,

avere un impatto positivo nell’uso delle video conferenze. Al di là di ciò, però, il loro esperimento inevitabilmente sottolinea

la facilità con cui le immagini possono essere distorte e il rischio connesso a queste metodologie.

Come alterare le immagini in diretta

I sistemi neurali non supervisionati

Insomma: il mondo delle “fake news” è tra noi. E sarà sempre più difficile contrastarlo. Anche perchè, ricorda sempre CBInsights,

l’Intelligenza artificiale, che ha mille risvolti positivi e può dare una grande mano all’uomo (basta pensare alla dignanostica

in medicina) ha un suo lato oscuro. È in grado di creare dei contenuti digitali completamente fasulli. Sono i casi in

cui vengono, ad esempio, sfruttati sistemi neurali non supervisionati. Cosa si intende? Per rispondere è necessario dapprima

ricordare che l’Ai può essere supervisionata oppure no. Nel primo caso, in parole semplici e senza pretesa di esaustività,

il “neural network” funziona così. Il sistema, in linea di massima, prevede un’operatività in parallelo e a più livelli.

L’informazione (input) viene immessa nel nodo (neurone simulato) il quale, dopo averla «elaborata», la trasmette ai nodi successivi e in parallelo. Si giunge così a un primo risultato (output) transitorio. Questo viene «passato» al livello superiore dove si ripete il processo. Di livello in livello la rete neurale, in modo autonomo, arriva all’elaborazione finale dell’informazione. Il processo, tuttavia, è per l’appunto supervisionato. L’input iniziale, un dato certo quale l’immagine di un uomo, deve essere coerente con l’output finale: la macchina viene addestrata a “considerare” l’immagine come un uomo. Fino a quando ciò non accade il procedimento viene ripetuto. Vale a dire: c’è la supervisione. Alla fine l’intelligenza artificiale riconoscerà l’uomo, e i percorsi seguiti nell’elaborare gli input saranno stati decisi in autonomia dall’Artificial intelligence (Ai).

Nell’Ai non supervisionata, al contrario, l’attività di allenamento per fare coincidere il risultato finale con quello iniziale

(la macchina riconosce il gatto in una foto di un gatto) non c’è. L’input è elaborato dal sistema neurale il quale, in maniera

autonoma, può dare luogo all’errore, all’output della notizia falsa. Questo procedimento viene a sua volta “monitorato” da

un altro sistema neurale che valuta se l’output falso è riconoscibile come tale oppure no. Fino a quando la seconda Ai non

rileva che l’informazione appare vera, il risultato del primo sistema non supervisionato viene rimandato indietro. Solo quando

il “neural system” di controllo riconosce la “fake news” come reale il processo sarà completo. Si dirà: qual è l’obiettivo

di tutto questo sforzo? Quello di dare vita a delle notizie, o parti di testo, che sono false ma appaiono fortemente vere.

Al di là dell’Ai non supervisionata, in generale va detto che i sistemi per realizzare le “fake news” funzionano bene con

i personaggi noti in quanto in Internet ci sono migliaia, se non milioni, di loro video e informazioni su di essi. Cioè:

le catene di montaggio della “fabbrica” delle “fake news” ha moltissima materia prima con cui lavorare. Questo, però, non

esclude che il fenomeno possa colpire ciascuno di noi. Le tecnologie progrediscono ed è sempre più facile falsificare immagini

con pochi dati forniti all’algoritmo. Per esempio la canadese Lyerbird, società che svolge attività assolutamente legali,

sta sviluppando un’innovazione che consente, grazie ad un audio di solo un minuto, di generare “speeches” artificiali differenti

e molto più lunghi.

La propaganda computazionale

Ma non è solo una questione di video o di audio. C’è anche il fronte della “Computational propaganda”. Cioè, in parole semplici,

degli algoritmi e dell’automazione della pubblicazione di news sfruttati al fine di sostenere, ad esempio, una determinata

campagna elettorale. Si tratta di un fenomeno che, secondo gli esperti, è spesso realizzato da gruppi organizzati “sotenuti”,

o indirettamente legati, a Stati. Uno studio dell’Oxford University ha trovato, ad esempio, che ci sono state campagne di

manipolazione dei social media come minimo in 28 Stati dal 2010.

La ricerca indica che «i regimi autoritari non sono gli unici (...) ad avere organizzato» simili attività. Il maggiore numero di casi, infatti, è stato rilevato negli Stati Uniti, poi in Russia e in Cina. Ciò detto: come vengono diffuse le notizie false o verosimili? Per comprendere appieno il fenomeno si deve «dapprima ricordare - sottolinea Lucio Lamberti, docente di Marketing alla School of Management del Politecnico di Milano - che questo si basa sul cosiddetto “bias” di conferma». Vale a dire? «È un atteggiamento, presente nell’essere umano, in forza del quale più che tentare di farsi una propria opinione, ad esempio su di un evento, si tende a cercare la conferma di quanto già sappiamo». È, in senso lato, un modo in cui si concretizza l’ancestrale comportamento di allontanare il dolore, la fatica.

«Crearsi una nuova opinione comporta uno sforzo, un lavoro». Bisogna capire se la fonte della “news” è attendibile; se sussiste

un conflitto d’interessi oppure se l’informazione è accurata o contiene degli errori. «Istintivamente l’essere umano tende

ad evitare quest’impegno».

La potenza dei computer e i dati personali

Orbene: all’interno del contesto descritto si inserisce un duplice fenomeno. Da un lato c’è la digitalizzazione dell’informazione

(Internet), con la contestuale espansione dei social network e disintermediazione dei media tradizionali. Dall’altro si

assiste all’evoluzione della potenza computazionale. Gli algoritmi, sempre più sofisticati, permettono di scandagliare in

lungo e in largo le tracce lasciate dagli utenti online: dai like sulle piattaforme social ai siti visitati fino ai video

scaricati e ai commenti scritti nelle chat. Una mole immensa d’informazioni (big data) che sono sfruttati a piene mani (non

sempre in maniera conforme alla legge) per definire gruppi (cluster) di persone.

Soggetti che, individuati nelle loro caratteristiche personali, diventano oggetti del micro-targeting della “fake new”.

Vale a dire: la falsa notizia non viene inviata a casaccio, bensì è spedita a quei soggetti che paiono essere più facilmente

“aggredibili” dalla finta informazione. In altre parole: che sono più propensi a crederci. Fantascienza? Assolutamente no.

CBInsights ricorda che in un’email di Cambridge Analytica (la società coinvolta nello scandalo sulle presunte illecite interferenze

nelle ultime elezioni presidenziali Usa) erano indicate moltissime caratteristiche attraverso cui riuscire a definire il comportamento

di un soggetto: dal “banale” orientamento politico e religioso fino alla predilezione per l’uso delle armi da fuoco o alla

credenza nell’astrologia.

Il gioco della condivisione

Ciò detto, però, resta la domanda: al di là del micro-targeting e il “bias” della conferma come riesce una “fake news” a diventare

virale, ad espandersi nel mondo di Internet? Attraverso il meccanismo della conferma. Si tratta di un altro “bias” che, in

parole semplici, consiste nell’ipotizzare che tutti la pensino come noi. È per questo che, in generale, ci troviamo spesso

con persone che hanno comportamenti simili ai nostri. Noi condividiamo le pagine dei social network con chi ci pare simile

o ci piace. Persone con cui non di rado abbiamo idee in comune. In tal senso «nel momento in cui un “amico sociale”, raggiunto

dalla “fake news” la rilancia, noi molto spesso facciamo lo stesso».

La pietra (la finta notizia) lanciata nell’acqua crea delle onde che, nel momento in cui quest’ultime vanno scemando, vengono rivitalizzate dal meccanismo della condivisione. Un sistema, peraltro, che viene dolosamente più che proporzionalmente allargato dall’uso di migliaia e migliaia “bot”. Computer il cui compito è proprio quello, in maniera mirata, di inviare la “fake news” e di rilanciarla più e più volte. Alla fine la palla di neve si trasforma in valanga.

«Va detto - aggiunge Giovanni Ziccardi, docente di Informatica giuridica all’Università degli Studi di Milano ed esperto del

settore - che nella propaganda politica di questo tipo la tecnica è la polarizzazione della discussione. Vengono scientificamente

individuati gli argomenti che sono divisivi. La notizia falsa deve avere a che fare con tematiche dove sia più facile indurre

delle posizioni “nette” e precise». In questo modo il target della “fake news”, già predisposto ad accettarla, darà il suo

assenso e la rilancerà. «Poi l’ “amico social”, che magari può pure avere dei dubbi, la riproporrà lui stesso». Perchè, avendola

postata uno di cui (più o meno) si condivide la visione della realtà, è comunque interessante. Ha un suo valore.

Le difese

Fin qui la descrizione della “fabbrica” delle “fake news”. Quali però le possibili mosse per contrastarla? «Combattere il

fenomeno è difficile -risponde Fabrizio Lillo, docente di finanza quantitativa all’Università di Bologna -. In una nostra

ricerca, in merito all’influenza dei social network sul trading a Wall Street, abbiamo scoperto che una larga parte degli

account era finta. Bot costituiti ad arte e quasi impossibili da individuare al semplice occhio umano. Una difesa, però,

può essere costituita dalla tecnologia stessa». In che modo? «La nostra idea è stata di individuare, attraverso dei software,

tutti gli account che si muovevano simultaneamente e in maniera simile. Così facendo siamo riusciti a scoprire gli “impostori”».

«Sono d’accordo - fa da eco Ziccardi. La tecnologia è fondamentale. Ad essa, tuttavia, deve aggiungersi l’intervento legislativo. Quando una notizia falsa costituisce, ad esempio, una diffamazione deve essere perseguita. E poi bisogna continuare a lavorare sul fronte della cultura, della conoscenza. È essenziale che concetti quali, ad esempio, l’attendibilità della fonte informativa si espandano il più possibile».

© Riproduzione riservata