Secondo gli ingegneri di Google non è molto diverso da quando guardiamo le nuvole, provando a scoprire in esse forme nascoste. Solo che questa volta sono i robot, gli algoritmi, a cercare di “super interpretare” singole immagini sulla base dei dati a disposizione. Con esiti incredibili, a metà tra il mondo onirico e gli stati di allucinazione, tra l’impressionismo di Claude Seurat e il surrealismo di Salvador Dalì.

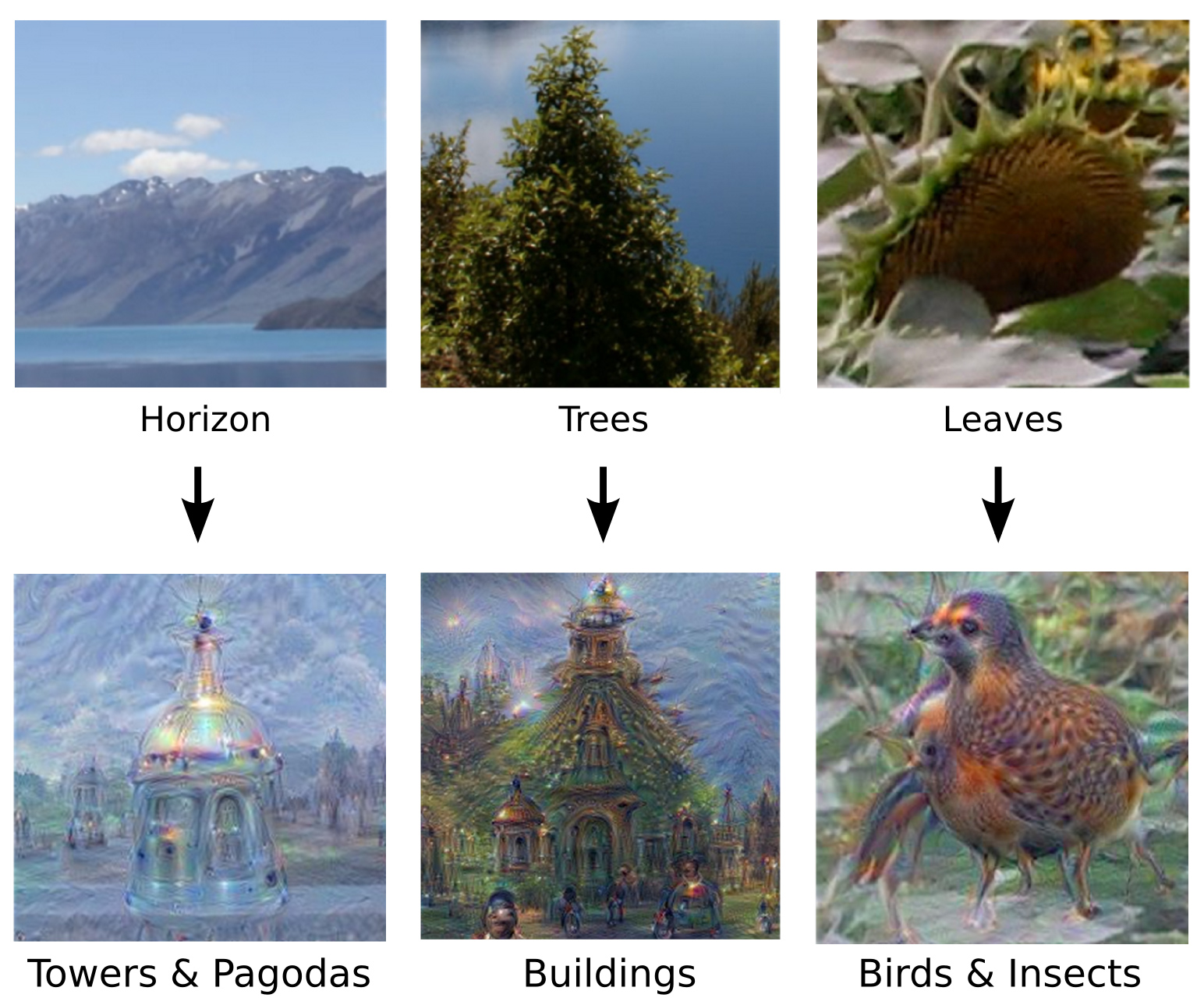

Vediamo meglio come “sognano” i robot. Gli ingegneri di “Big G” hanno caricato su un software le immagini di un paesaggio, di un albero e di una foglia, ma senza domandare semplicemente alle macchine di spiegare che cosa rappresenta l’immagine. Durante un esperimento sulle reti neurali (ossia sui software in grado di apprendere utilizzando logiche in parte simili a quelle del cervello umano) i programmatori di Google hanno chiesto al robot di “enfatizzare” quello che vede, di cercare di “sovra interpretarlo” in base all’enorme mole di dati che ha in memoria. Ecco il risultato:

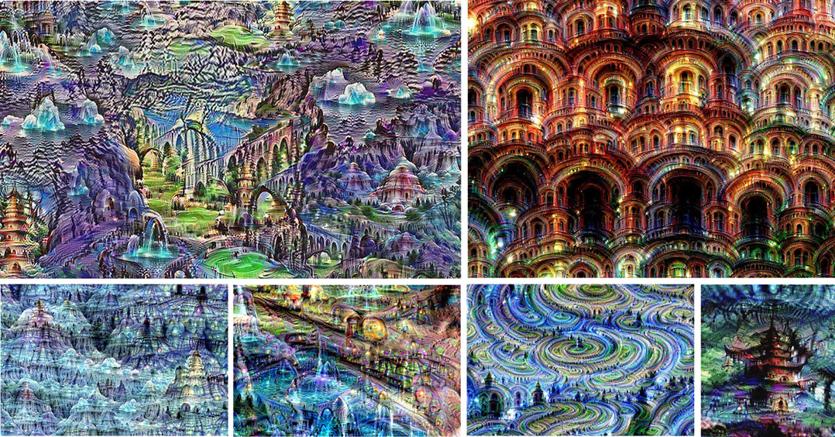

Non a caso i programmatori di Google hanno battezzato questo programma “Deep Dream”, sogno profondo, anche se per la verità più che in una semplice dimensione onirica qui sembra di trovarsi in pieno “acid trip” psichedelico. «Queste reti neurali erano state addestrate soprattutto a riconoscere immagini di animali - spiegano Mike Tyka, Alexander Mordvintsev e Christopher Olah, ingegneri di “Big G” - . Il risultato per la verità varia a seconda dei tipi di immagine, per esempio con le linee orizzontali che tendono a venire “riempite” con grattacieli o pagode, mentre rocce e alberi diventano edifici, con foglie che invece si trasformano uccelli». In altri casi, invece, alcune parti delle figure diventano semplici ghirigori ornamentali, senza generare altre immagini.

Fin qui gli ingegneri, focalizzati sugli aspetti più tecnici. Ma è quando si interpellano gli neuroscienziati che la musica diventa interessante. Sì, perché si scopre che le visioni lisergiche delle reti neurali non sono così lontane da quelle degli esseri umani. «Non dimentichiamo che le nostre allucinazioni corrispondono sì in qualche modo a quello che esiste davvero nel mondo esterno, ma sono soprattutto frutto di percezioni generate a livello interiore», spiega Lucas Sjulson, ricercatore all’Istituto di Neuroscienza dell’Università di New York. La gente pensa che i nostri occhi siano come l’obiettivo di una telecamera, e in effetti danno la possibilità di vedere, ma in realtà è il cervello che elabora le immagini dando loro un senso. L’assunzione di allucinogeni non altera la nostra visione, sottolinea Sjulson, ma l’elaborazione delle forme e dei colori da parte del cervello.

In fondo quindi non siamo così diversi dalle macchine, spiegano gli scienziati, anche perché apprendiamo dall’esperienza visuale esattamente come i robot in questo specifico caso. «È infatti la nostra corteccia cerebrale, non i nostri occhi, a essere “programmata” per cercare forme riconoscibili - spiega Jeffrey Guss, psichiatra all’Università di New York - per cercare di “vedere qualcosa” nelle informazioni fornite dai nostri occhi. Ci sono dozzine di esperimenti psicologici che dimostrano come spesso vediamo quello che ci aspettiamo di vedere, quello che ci è stato detto di vedere, anziché quello che è davvero di fronte a noi».

Probabilmente questo specifico esperimento sulle reti neurali dimostra come, per alcuni aspetti, l’intelligenza artificiale sia più simile a quella umana di quanto si pensi. «Il fatto che gli esseri umani percepiscano le immagini generate dagli algoritmi come allucinazioni sotto l’effetto di droghe suggerisce come in fondo, sotto il cofano, il nostro cervello sia per certi versi simile alle reti neurali delle intelligenze artificiali».

© Riproduzione riservata